Bidirectional Encoder Representations from Transformers

| Bidirectional encoder representations from transformers (BERT) | |

|---|---|

| Basisdaten

| |

| Entwickler | Google AI |

| Erscheinungsjahr | 31 Oktober 2018 |

| Kategorie | Transformer, Large Language Model |

| Lizenz | Apache 2.0 |

| https://github.com/google-research/bert | |

Bidirectional encoder representations from transformers (kurz BERT) ist ein Sprachmodell, das im Oktober 2018 von Forschenden bei Google vorgestellt wurde.[1][2] Es lernt, Text als Sequenz von Vektoren darzustellen, und nutzt dafür selbstüberwachtes Lernen. Die Architektur basiert auf einem reinen Encoder-Transformer. BERT verbesserte den Stand der Technik bei großen Sprachmodellen deutlich. Seit 2020 dient BERT in Experimenten zur Verarbeitung natürlicher Sprache (natural language processing, NLP) weitverbreitet als Basismodell.[3]

Trainiert wird BERT über Masken-Vorhersage einzelner Token sowie die Vorhersage der nächsten Satzfolge. Auf diese Weise lernt BERT kontextabhängige, latente Repräsentationen von Token in ihrem Kontext, ähnlich wie ELMo und GPT-2.[4] Das Modell findet Anwendung in vielen Aufgaben der Sprachverarbeitung, etwa bei der Koreferenzauflösung oder bei der Auflösung von Polysemie.[5] BERT verbesserte gegenüber ELMo die Ergebnisse und führte zu einem eigenen Forschungsgebiet, der sogenannten „BERTology“, das untersucht, was das Modell intern lernt.

Ursprünglich wurde BERT für die englische Sprache in zwei Modellgrößen eingeführt: BERTBASE (110 Millionen Parameter) und BERTLARGE (340 Millionen Parameter). Beide Modelle wurden auf dem Toronto-BookCorpus[6] (800 Mio. Wörter) und der englischsprachigen Wikipedia (2 500 Mio. Wörter) vortrainiert. Die Gewichte wurden auf GitHub veröffentlicht.[7] Am 11. März 2020 wurden zusätzlich 24 kleinere Modelle veröffentlicht, das kleinste davon BERTTINY mit lediglich 4 Millionen Parametern.

Architektur

[Bearbeiten | Quelltext bearbeiten]

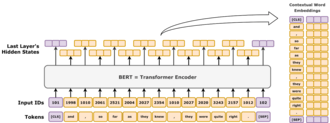

BERT verwendet eine reine Encoder-Transformer-Architektur („encoder-only“). Auf hoher Ebene besteht BERT aus vier Modulen: Tokenizer: Dieses Modul wandelt englischen Text in eine Sequenz ganzer Zahlen („Token“) um.

Embedding: Dieses Modul wandelt die Token-Sequenz in ein Array reellwertiger Vektoren um, die die Token repräsentieren. Dabei werden diskrete Token-Typen in einen niedrigdimensionalen euklidischen Raum abgebildet.

Encoder: Ein Stapel von Transformer-Blöcken mit Self-Attention, jedoch ohne kausale Maskierung.

Task-Head: Dieses Modul bildet die endgültigen Repräsentationsvektoren wieder auf one-hot-kodierte Token ab, indem es eine Wahrscheinlichkeitsverteilung über alle Token-Typen berechnet. Es kann als einfacher Decoder interpretiert werden, der die latente Repräsentation in Token-Typen zurückübersetzt, oder als „Un-Embedding-Schicht“.

Der Task-Head ist für das Vortraining erforderlich, wird aber bei sogenannten „Downstream-Aufgaben“ wie Fragebeantwortung oder Sentimentklassifikation häufig durch ein neues, auf die Zielaufgabe zugeschnittenes Modul ersetzt. Dazu wird der ursprüngliche Head entfernt, ein neuer Kopf für die jeweilige Aufgabe hinzugefügt und gemeinsam mit dem restlichen Modell feinabgestimmt (Fine-Tuning). Die latente Vektorrepräsentation dient dabei als Eingabe für das neue Modul und ermöglicht eine datenökonomische Transferlern-Strategie.[8]

Embedding

[Bearbeiten | Quelltext bearbeiten]Dieser Abschnitt beschreibt das Embedding von BERTBASE. BERTLARGE ist ähnlich aufgebaut, aber größer. Der Tokenizer von BERT ist WordPiece, eine Subwort-Strategie ähnlich der Byte-Pair-Codierung. Der Wortschatz (Vocabulary) umfasst 30 000 Einträge; Token, die nicht im Wortschatz auftreten, werden durch [UNK] („unknown“) ersetzt.

Die erste Schicht ist die Embedding-Schicht mit drei Komponenten: Token-Embeddings, Positions-Embeddings und Segment-Typ-Embeddings. Token-Typ: Das Token-Embedding ist eine Standard-Einbettungsschicht, die eine one-hot-kodierte Repräsentation eines Tokens in einen dichten Vektor übersetzt.

Position: Positions-Embeddings hängen von der Position eines Tokens in der Sequenz ab. BERT verwendet absolute Positions-Embeddings, bei denen jede Position einer Sequenz einem reellwertigen Vektor zugeordnet wird. Jede Dimension dieses Vektors ist eine sinusförmige Funktion der Positionsnummer.

Segment-Typ: Mit einem Vokabular aus nur 0 und 1 kodiert diese Schicht, ob ein Token zum ersten oder zweiten Textsegment im Eingabepaar gehört. Typ-1-Token sind alle Token, die nach dem speziellen Token [SEP] auftreten; alle vorhergehenden Token sind Typ-0.

Die drei Embedding-Vektoren werden komponentenweise addiert und bilden so die initiale Token-Repräsentation als Funktion dieser drei Informationsquellen. Anschließend wird der Vektor mit LayerNorm normalisiert, sodass für jedes Eingabetoken ein 768-dimensionaler Vektor entsteht. Diese Repräsentationen werden durch 12 Transformer-Encoder-Blöcke weiterverarbeitet und abschließend mittels einer affinen Transformation zurück in den 30 000-dimensionalen Wortschatzraum projiziert.

Architekturfamilie

[Bearbeiten | Quelltext bearbeiten]Der Encoder-Stack von BERT hat zwei freie Hyperparameter: L, die Anzahl der Schichten (Layer), und H, die Hidden Size. Die Anzahl der Self-Attention-Köpfe ist stets H/64, und die Dimension der Feed-Forward-Schicht (Filter Size) beträgt immer 4H. Durch Variation dieser beiden Größen entsteht eine ganze Familie von BERT-Modellen.[9]

Für BERT gilt:

Feed-Forward-Size und Filter-Size sind synonym und bezeichnen die Anzahl der Dimensionen in der mittleren Schicht des Feed-Forward-Netzes.

Hidden Size und Embedding Size sind synonym und bezeichnen die Anzahl der reellen Zahlen, mit denen ein Token repräsentiert wird.

Die Architektur wird als L/H notiert. BERTBASE hat beispielsweise 12L/768H, BERTLARGE 24L/1024H und BERTTINY 2L/128H.

Training

[Bearbeiten | Quelltext bearbeiten]Vortraining

[Bearbeiten | Quelltext bearbeiten]BERT wurde gleichzeitig auf zwei Aufgaben vortrainiert:[10]

Masked Language Modeling (MLM): Hier erhält BERT eine Wortsequenz, in der ein Teil der Wörter zufällig verändert („maskiert“) wurde, und soll die ursprünglichen Wörter rekonstruieren. In dem Satz „The cat sat on the [MASK]“ soll das Modell beispielsweise „mat“ vorhersagen. Dies ermöglicht es BERT, bidirektionalen Kontext zu nutzen, also Beziehungen zwischen Wörtern gleichzeitig von links nach rechts und von rechts nach links zu modellieren.

Next Sentence Prediction (NSP): In dieser Aufgabe lernt BERT zu entscheiden, ob ein Satz tatsächlich auf einen anderen Satz folgt. Bei den Sätzen „The cat sat on the mat“ und „It was a sunny day“ soll das Modell bestimmen, ob der zweite Satz eine plausible Fortsetzung des ersten ist. Dadurch lernt BERT Relationen zwischen Sätzen, was für Aufgaben wie Fragebeantwortung oder Dokumentklassifikation wichtig ist.

Masked Language Modeling

[Bearbeiten | Quelltext bearbeiten]

Beim Masked Language Modeling werden zufällig 15 % der Token einer Eingabesequenz ausgewählt. Das Trainingsziel besteht darin, diese ausgewählten Token anhand ihres Kontexts korrekt vorherzusagen. Das ausgewählte Token wird dabei wie folgt behandelt: mit Wahrscheinlichkeit 80 % durch das spezielle Token [MASK] ersetzt,

mit Wahrscheinlichkeit 10 % durch ein zufälliges Token aus dem Vokabular ersetzt,

mit Wahrscheinlichkeit 10 % unverändert gelassen.

Nicht alle ausgewählten Token werden also maskiert. Dies soll einen Dataset Drift vermeiden: Die Verteilung der Eingaben während des Trainings würde sonst stark von der Verteilung der Eingaben beim Einsatz abweichen, wo typischerweise keine [MASK]-Token vorkommen (z. B. beim Einsatz als Wortrepräsentation ähnlich Word2Vec). Spätere Arbeiten zeigen, dass vielfältigere Trainingsziele generell vorteilhaft sind.[11]

Als Beispiel sei der Satz „my dog is cute“ betrachtet. Zunächst wird er in Token zerlegt: „my1 dog2 is3 cute4“. Angenommen, das vierte Token „cute4“ wird ausgewählt. Dann ergeben sich drei Möglichkeiten:

mit 80 % Wahrscheinlichkeit wird es maskiert: „my1 dog2 is3 [MASK]4“;

mit 10 % Wahrscheinlichkeit wird es durch ein zufälliges Token wie „happy“ ersetzt: „my1 dog2 is3 happy4“;

mit 10 % Wahrscheinlichkeit bleibt es unverändert: „my1 dog2 is3 cute4“.

Nach der Verarbeitung durch das Modell wird der vierte Ausgabeverktor an den Decoder weitergegeben, der eine Wahrscheinlichkeitsverteilung über den 30 000-dimensionalen Wortschatz berechnet.

Next Sentence Prediction

[Bearbeiten | Quelltext bearbeiten]

Beim NSP erhält das Modell zwei Sätze und soll entscheiden, ob sie im Trainingskorpus direkt aufeinander folgen ([IsNext]) oder nicht ([NotNext]). Für das Training werden zu einem Teil der Beispiele zwei Sätze aus einem zusammenhängenden Abschnitt des Korpus gewählt, für andere Beispiele stammen sie aus zwei nicht zusammenhängenden Abschnitten. Der erste Satz beginnt mit dem speziellen Token [CLS] („classify“). Die beiden Sätze werden durch [SEP] („separate“) getrennt. Nach der Verarbeitung dient der endgültige Vektor des [CLS]-Tokens als Eingabe für eine lineare Schicht, die die binäre Klassifikation in [IsNext] oder [NotNext] durchführt.

Beispiele:

Für „[CLS] my dog is cute [SEP] he likes playing [SEP]“ soll das Modell [IsNext] ausgeben.

Für „[CLS] my dog is cute [SEP] how do magnets work [SEP]“ soll es [NotNext] ausgeben.

Fine-Tuning

[Bearbeiten | Quelltext bearbeiten]BERT ist als allgemein vortrainiertes Modell für verschiedene Anwendungen in der Verarbeitung natürlicher Sprache konzipiert. Nach dem Vortraining kann BERT mit relativ geringem Aufwand auf kleineren Datensätzen für spezifische Aufgaben feinabgestimmt werden, etwa für natürliche Sprachinferenz, Textklassifikation oder sequenzbasierte Generierungsaufgaben wie Fragebeantwortung und dialogorientierte Antwortgenerierung.[12]

Im ursprünglichen BERT-Artikel wurde gezeigt, dass bereits eine kurze Feinabstimmung (für BERTLARGE etwa eine Stunde auf einem Cloud-TPU) ausreicht, um auf einer Reihe von Aufgaben der sprachlichen Bedeutungserschließung den damaligen Stand der Technik zu erreichen:

GLUE-Datensatz (General Language Understanding Evaluation) mit neun Teilaufgaben;

SQuAD (Stanford Question Answering Dataset) v1.1 und v2.0;[13]

SWAG (Situations With Adversarial Generations).[14]

Im Originalvorschlag werden alle Parameter von BERT beim Fine-Tuning angepasst. Für textklassifizierende Anwendungen wird empfohlen, den Ausgabeverktor des [CLS]-Tokens an eine lineare Schicht mit Softmax-Aktivierung anzuschließen, um die Klassenzugehörigkeit vorherzusagen.

Im ursprünglichen Quellcode wird diese letzte lineare Schicht analog zu Global Pooling in der Bildverarbeitung als „Pooler Layer“ bezeichnet, auch wenn sie lediglich alle Token-Ausgaben bis auf die des [CLS]-Tokens verwirft.[15]

Kosten

[Bearbeiten | Quelltext bearbeiten]BERT wurde auf dem BookCorpus (800 Mio. Wörter) und einer gefilterten Version der englischen Wikipedia (2 500 Mio. Wörter, ohne Listen, Tabellen und Überschriften) trainiert. Das Training von BERTBASE auf 4 Cloud-TPUs (16 TPU-Chips) dauerte vier Tage und kostete Schätzungen zufolge etwa 500 US-Dollar. Das Training von BERTLARGE auf 16 Cloud-TPUs (64 TPU-Chips) dauerte ebenfalls vier Tage.

Interpretation

[Bearbeiten | Quelltext bearbeiten]Sprachmodelle wie ELMo, GPT-2 und BERT haben das Forschungsfeld der „BERTology“ angestoßen, das versucht zu verstehen, was diese Modelle intern repräsentieren. Ihr Abschneiden auf Aufgaben der sprachlichen Bedeutungserschließung ist trotz der hohen Leistungswerte nicht vollständig erklärt.[16] [17] Zahlreiche Arbeiten aus den Jahren 2018 und 2019 analysieren den Zusammenhang zwischen speziellen Eingabesequenzen und den vom Modell erzeugten Ausgaben,[18] [19] untersuchen interne Vektorraumrepräsentationen durch sogenannte Probing-Klassifikatoren,[20] [21] und analysieren die durch die Attention-Gewichte dargestellten Beziehungen. Die hohe Leistungsfähigkeit von BERT wird unter anderem darauf zurückgeführt, dass das Modell bidirektional trainiert wird.[22] Auf Basis der Transformer-Architektur nutzt BERT die Self-Attention, um Informationen sowohl von links als auch von rechts gleichzeitig auszuwerten und so Kontexte zuverlässig zu erfassen. Das Wort fine hat beispielsweise in „I feel fine today“ und „She has fine blond hair“ unterschiedliche Bedeutungen; BERT berücksichtigt jeweils die umgebenden Wörter auf beiden Seiten.

Die Architektur bringt jedoch Einschränkungen mit sich: Da es sich um ein reines Encoder-Modell ohne Decoder handelt, kann BERT nicht direkt für Prompting und Textgenerierung eingesetzt werden. Bidirektionale Modelle sind im Allgemeinen auf Kontext sowohl links als auch rechts angewiesen und eignen sich daher schlecht für Aufgaben, bei denen der rechte Kontext während der Generierung fehlt. Möchte man beispielsweise mit BERT den Satzanfang „Today, I went to“ fortsetzen, könnte man naiv alle noch zu generierenden Token als [MASK] markieren: „Today, I went to [MASK] [MASK] [MASK] … [MASK].“ Während des Trainings wurden jedoch nie Eingaben mit so vielen maskierten Token verwendet; dies führt zu einem starken Verteilungsunterschied und deutlichem Leistungsabfall. Es existieren zwar Verfahren, mit denen auch auf Basis bidirektionaler Encoder Text generiert werden kann, diese sind jedoch rechenaufwendig.[23]

Geschichte

[Bearbeiten | Quelltext bearbeiten]BERT wurde von den Google-Forschenden Jacob Devlin, Ming-Wei Chang, Kenton Lee und Kristina Toutanova entwickelt. Die Architektur baut auf früheren Arbeiten zu kontextabhängigen Repräsentationen auf, darunter semi-supervised sequence learning,[24] und ULMFiT.[25] Im Unterschied zu diesen Vorgängermodellen ist BERT ein tiefes, bidirektionales und unüberwachtes Sprachrepräsentationsmodell, das ausschließlich auf einem einfachen Textkorpus vortrainiert wird. Kontextfreie Modelle wie word2vec oder GloVe erzeugen für jedes Wort im Vokabular einen einzigen Einbettungsvektor, während BERT für jede Wortverwendung eine kontextualisierte Einbettung berechnet. Das Wort „running“ erhält beispielsweise in „He is running a company“ und „He is running a marathon“ unterschiedliche Repräsentationen.

Am 25. Oktober 2019 gab Google bekannt, BERT-Modelle für englischsprachige Suchanfragen in den USA in Google Search einzusetzen.[26] Am 9. Dezember 2019 wurde berichtet, dass BERT in Google Search für über 70 Sprachen verwendet wird.[27] [28] Im Oktober 2020 wurde gemeldet, dass nahezu jede englischsprachige Suchanfrage von einem BERT-Modell verarbeitet werde.[29]

Varianten

[Bearbeiten | Quelltext bearbeiten]Die BERT-Modelle waren einflussreich und führten zu zahlreichen Varianten. RoBERTa (2019)[30] ist eine vor allem technisch optimierte Variante. Die Architektur von BERT bleibt im Wesentlichen erhalten (leicht vergrößert auf 355 Mio. Parameter), doch werden Trainingshyperparameter geändert, die Aufgabe der Next Sentence Prediction entfernt und deutlich größere Mini-Batchsizes verwendet.

XLM-RoBERTa (2019)[31] ist eine mehrsprachige RoBERTa-Variante und eine der ersten Arbeiten zu Sprachmodellierung im großen Maßstab über viele Sprachen hinweg.

DistilBERT (2019) distilliert BERTBASE zu einem Modell mit nur 60 % der Parameter (66 Mio.), bei etwa 95 % der ursprünglichen Benchmark-Ergebnisse.[32] [33] TinyBERT (2019)[34] ist ebenfalls ein destilliertes Modell mit nur 28 % der Parameter des Ausgangsmodells.

ALBERT (2019)[35] führt schichtübergreifend geteilte Parameter ein und variiert Hidden Size und Embedding-Dimension unabhängig als zwei Hyperparameter. Zudem wird die Aufgabe der Next Sentence Prediction durch Sentence-Order Prediction (SOP) ersetzt, bei der das Modell entscheiden muss, ob zwei aufeinanderfolgende Textsegmente in der richtigen oder vertauschten Reihenfolge vorliegen.

ELECTRA (2020)[36] überträgt Ideen generativer adversarieller Netze auf die MLM-Aufgabe. Statt Token zu maskieren, erzeugt ein kleines Sprachmodell plausible Ersetzungen, und ein größeres Netz lernt, ersetzte Tokens zu erkennen. Das kleine Modell versucht dabei, das große zu „täuschen“.

DeBERTa (2020)[37] stellt eine deutlich veränderte Architektur mit „disentangled attention“ vor. Die zentrale Idee ist, Positions- und Token-Encodings in der Attention getrennt zu behandeln. Statt beide Komponenten zu einem Eingabevektor zu addieren (), werden sie als Tupel geführt. In jeder Self-Attention-Schicht berechnet DeBERTa drei verschiedene Aufmerksamkeitsmatrizen, statt einer einzigen wie in BERT:[note 1]

| Aufmerksamkeits-Typ | Query-Typ | Key-Typ | Beispiel |

|---|---|---|---|

| Content-to-content | Token | Token | „European“; „Union“; „continent“ |

| Content-to-position | Token | Position | [Adjektiv]; +1; +2; +3 |

| Position-to-content | Position | Token | −1; „not“; „very“ |

Die drei Aufmerksamkeitsmatrizen werden elementweise addiert, durch eine Softmax-Schicht normalisiert und anschließend mit einer Projektionsmatrix multipliziert.

Absolute Positionscodierung wird in der letzten Self-Attention-Schicht zusätzlich in den Eingang eingespeist.

Anmerkungen

[Bearbeiten | Quelltext bearbeiten]- ↑ Der Position-zu-Position-Typ wurde von den Autoren weggelassen, da er als nutzlos angesehen wurde.

Literatur

[Bearbeiten | Quelltext bearbeiten]- Rogers, Anna; Kovaleva, Olga; Rumshisky, Anna: A Primer in BERTology: What We Know About How BERT Works. 2020, arxiv:2002.12327 (englisch).

Weblinks

[Bearbeiten | Quelltext bearbeiten]Einzelnachweise

[Bearbeiten | Quelltext bearbeiten]- ↑ Devlin, Jacob; Chang, Ming-Wei; Lee, Kenton; Toutanova, Kristina: BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding. 11. Oktober 2018, abgerufen am 5. Dezember 2025 (englisch).

- ↑ Open Sourcing BERT: State-of-the-Art Pre-training for Natural Language Processing. In: Google AI Blog. 11. November 2018, abgerufen am 27. November 2019 (englisch).

- ↑ Rogers, Anna; Kovaleva, Olga; Rumshisky, Anna: A Primer in BERTology: What We Know About How BERT Works. In: Transactions of the Association for Computational Linguistics. Band 8, 2020, S. 842–866, doi:10.1162/tacl_a_00349 (englisch, aclanthology.org).

- ↑ Ethayarajh, Kawin: How Contextual are Contextualized Word Representations? Comparing the Geometry of BERT, ELMo, and GPT-2 Embeddings. 1. September 2019, abgerufen am 5. Dezember 2025 (englisch).

- ↑ Anderson, Dawn: A deep dive into BERT: How BERT launched a rocket into natural language understanding. In: Search Engine Land. 5. November 2019, abgerufen am 6. August 2024 (englisch).

- ↑ Zhu, Yukun; Kiros, Ryan; Zemel, Rich; Salakhutdinov, Ruslan; Urtasun, Raquel; Torralba, Antonio; Fidler, Sanja: Aligning Books and Movies: Towards Story-Like Visual Explanations by Watching Movies and Reading Books. 2015, S. 19–27, abgerufen am 5. Dezember 2025 (englisch).

- ↑ BERT. In: GitHub. Abgerufen am 28. März 2023 (englisch).

- ↑ Zhang, Tianyi; Wu, Felix; Katiyar, Arzoo; Weinberger, Kilian Q.; Artzi, Yoav: Revisiting Few-sample BERT Fine-tuning. 11. März 2021, abgerufen am 5. Dezember 2025 (englisch).

- ↑ Turc, Iulia; Chang, Ming-Wei; Lee, Kenton; Toutanova, Kristina: Well-Read Students Learn Better: On the Importance of Pre-training Compact Models. 25. September 2019, abgerufen am 5. Dezember 2025 (englisch).

- ↑ Summary of the models — transformers 3.4.0 documentation. In: huggingface.co. Abgerufen am 5. Dezember 2025 (englisch).

- ↑ Tay, Yi; Dehghani, Mostafa; Tran, Vinh Q.; Garcia, Xavier; Wei, Jason; Wang, Xuezhi; Chung, Hyung Won; Shakeri, Siamak; Bahri, Dara: UL2: Unifying Language Learning Paradigms. 28. Februar 2023, abgerufen am 5. Dezember 2025 (englisch).

- ↑ a b Zhang, Aston; Lipton, Zachary; Li, Mu; Smola, Alexander J.: Dive into Deep Learning. Cambridge University Press, Cambridge; New York; Port Melbourne; New Delhi; Singapore 2024, ISBN 978-1-00-938943-3, 11.9: Large-Scale Pretraining with Transformers (englisch, d2l.ai [abgerufen am 5. Dezember 2025]).

- ↑ Rajpurkar, Pranav; Zhang, Jian; Lopyrev, Konstantin; Liang, Percy: SQuAD: 100,000+ Questions for Machine Comprehension of Text. 10. Oktober 2016, abgerufen am 15. Februar 2025 (englisch).

- ↑ Zellers, Rowan; Bisk, Yonatan; Schwartz, Roy; Choi, Yejin: SWAG: A Large-Scale Adversarial Dataset for Grounded Commonsense Inference. 15. August 2018, abgerufen am 15. Februar 2025 (englisch).

- ↑ bert/modeling.py at master · google-research/bert. In: GitHub. Abgerufen am 16. September 2024 (englisch).

- ↑ Kovaleva, Olga; Romanov, Alexey; Rogers, Anna; Rumshisky, Anna: Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing (EMNLP-IJCNLP). 2019, Revealing the Dark Secrets of BERT, S. 4364–4373, doi:10.18653/v1/D19-1445 (englisch, aclweb.org).

- ↑ Clark, Kevin; Khandelwal, Urvashi; Levy, Omer; Manning, Christopher D.: What Does BERT Look at? An Analysis of BERT's Attention. In: Proceedings of the 2019 ACL Workshop BlackboxNLP: Analyzing and Interpreting Neural Networks for NLP. Association for Computational Linguistics, Stroudsburg, PA, USA 2019, S. 276–286, doi:10.18653/v1/W19-4828 (englisch, aclanthology.org).

- ↑ Khandelwal, Urvashi; He, He; Qi, Peng; Jurafsky, Dan: Sharp Nearby, Fuzzy Far Away: How Neural Language Models Use Context. In: Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). Association for Computational Linguistics, Stroudsburg, PA, USA 2018, S. 284–294, doi:10.18653/v1/P18-1027 (englisch, aclanthology.org).

- ↑ Gulordava, Kristina; Bojanowski, Piotr; Grave, Edouard; Linzen, Tal; Baroni, Marco: Proceedings of the 2018 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long Papers). Association for Computational Linguistics, Stroudsburg, PA, USA 2018, Colorless Green Recurrent Networks Dream Hierarchically, S. 1195–1205, doi:10.18653/v1/N18-1108 (englisch, aclanthology.org).

- ↑ Giulianelli, Mario; Harding, Jack; Mohnert, Florian; Hupkes, Dieuwke; Zuidema, Willem: Under the Hood: Using Diagnostic Classifiers to Investigate and Improve How Language Models Track Agreement Information. In: Proceedings of the 2018 EMNLP Workshop BlackboxNLP: Analyzing and Interpreting Neural Networks for NLP. Association for Computational Linguistics, Stroudsburg, PA, USA 2018, S. 240–248, doi:10.18653/v1/W18-5426 (englisch, aclanthology.org).

- ↑ Zhang, Kelly; Bowman, Samuel: Language Modeling Teaches You More than Translation Does: Lessons Learned Through Auxiliary Syntactic Task Analysis. In: Proceedings of the 2018 EMNLP Workshop BlackboxNLP: Analyzing and Interpreting Neural Networks for NLP. Association for Computational Linguistics, Stroudsburg, PA, USA 2018, S. 359–361, doi:10.18653/v1/W18-5448 (englisch, aclanthology.org).

- ↑ Sur, Chiranjib: RBN: Enhancement in Language Attribute Prediction Using Global Representation of Natural Language Transfer Learning Technology Like Google BERT. In: SN Applied Sciences. Band 2, Nr. 22, 2020, doi:10.1007/s42452-019-1765-9 (englisch).

- ↑ Patel, Ajay; Li, Bryan; Rasooli, Mohammad Sadegh; Constant, Noah; Raffel, Colin; Callison-Burch, Chris: Bidirectional Language Models Are Also Few-shot Learners. 2022, abgerufen am 15. Februar 2025 (englisch).

- ↑ Dai, Andrew; Le, Quoc: Semi-supervised Sequence Learning. 4. November 2015, abgerufen am 15. Februar 2025 (englisch).

- ↑ Howard, Jeremy; Ruder, Sebastian: Universal Language Model Fine-tuning for Text Classification. 18. Januar 2018, abgerufen am 15. Februar 2025 (englisch).

- ↑ Nayak, Pandu: Understanding searches better than ever before. In: Google Blog. 25. Oktober 2019, abgerufen am 10. Dezember 2019 (englisch).

- ↑ Understanding searches better than ever before. In: Google. 25. Oktober 2019, abgerufen am 6. August 2024 (englisch).

- ↑ Montti, Roger: Google's BERT Rolls Out Worldwide. In: Search Engine Journal. 10. Dezember 2019, abgerufen am 10. Dezember 2019 (englisch).

- ↑ Google: BERT now used on almost every English query. In: Search Engine Land. 15. Oktober 2020, abgerufen am 24. November 2020 (englisch).

- ↑ Liu, Yinhan; Ott, Myle; Goyal, Naman; Du, Jingfei; Joshi, Mandar; Chen, Danqi; Levy, Omer; Lewis, Mike; Zettlemoyer, Luke; Stoyanov, Veselin: RoBERTa: A Robustly Optimized BERT Pretraining Approach. 2019, abgerufen am 15. Februar 2025 (englisch).

- ↑ Conneau, Alexis; Khandelwal, Kartikay; Goyal, Naman; Chaudhary, Vishrav; Wenzek, Guillaume; Guzmán, Francisco; Grave, Edouard; Ott, Myle; Zettlemoyer, Luke; Stoyanov, Veselin: Unsupervised Cross-lingual Representation Learning at Scale. 2019, abgerufen am 15. Februar 2025 (englisch).

- ↑ Sanh, Victor; Debut, Lysandre; Chaumond, Julien; Wolf, Thomas: DistilBERT, a Distilled Version of BERT: Smaller, Faster, Cheaper and Lighter. 29. Februar 2020, abgerufen am 15. Februar 2025 (englisch).

- ↑ DistilBERT. In: huggingface.co. Abgerufen am 5. August 2024 (englisch).

- ↑ Jiao, Xiaoqi; Yin, Yichun; Shang, Lifeng; Jiang, Xin; Chen, Xiao; Li, Linlin; Wang, Fang; Liu, Qun: TinyBERT: Distilling BERT for Natural Language Understanding. 15. Oktober 2020, abgerufen am 15. Februar 2025 (englisch).

- ↑ Lan, Zhenzhong; Chen, Mingda; Goodman, Sebastian; Gimpel, Kevin; Sharma, Piyush; Soricut, Radu: ALBERT: A Lite BERT for Self-supervised Learning of Language Representations. 8. Februar 2020, abgerufen am 15. Februar 2025 (englisch).

- ↑ Clark, Kevin; Luong, Minh-Thang; Le, Quoc V.; Manning, Christopher D.: ELECTRA: Pre-training Text Encoders as Discriminators Rather Than Generators. 23. März 2020, abgerufen am 15. Februar 2025 (englisch).

- ↑ He, Pengcheng; Liu, Xiaodong; Gao, Jianfeng; Chen, Weizhu: DeBERTa: Decoding-enhanced BERT with Disentangled Attention. 6. Oktober 2021, abgerufen am 15. Februar 2025 (englisch).